Google DeepMind部门本周公布一款能执行在机器人上的Gemini Robotics On-Device,不需网络也能执行,并且具备高度任务泛化能力。

今年3月,Google介绍了一款视觉语言动作(vision language action,VLA)模型,将Gemini 2.0的多模态推理和实体世界理解能力带来机器人领域。而本周Google DeepMind进一步公布Gemini Robotics On-Device,是该公司可直接执行在机器人上的最强大模型。且由于Gemini Robotics On-Device的模型运行不依赖数据网络,因而适合对延迟性十分敏感的应用程序,在带宽不稳甚至没有网络地区也能稳定运行。

Gemini Robotics On-Device是双臂机器人的基础模型,只需最少的计算资源。它是创建在Gemini Robotics的任务泛化及灵活性基础上而开发。Google强调它设计宗旨是快速实验、灵活操控泸深投,能通过微调适应新任务,而且能在本地执行低延迟性的推论。

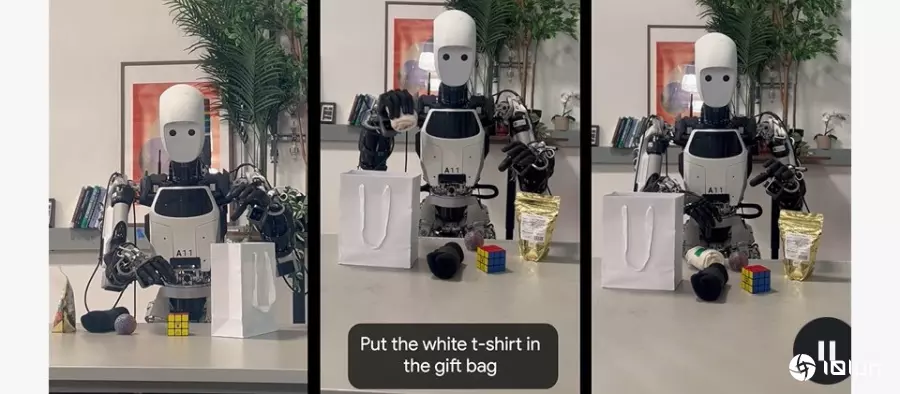

Gemini Robotics On-Device能在多种测试场景展现强大的视觉、语义和行为泛化能力,超越Gemini Robotics和其他设备上执行的模型,且能遵从自然语言指令,通过在机器人端执行而完成高难度任务,像是解开袋子拉链,或折叠衣服。

图片来源/Google

Gemini Robotics On-Device也是Google首个开放微调的VLA模型。它在未微调情况下也能执行众多任务,但开发人员还是可以加以微调以适应新领域,过程中开发人员只需给予50到100次示范。

Gemini Robotics On-Device是以ALOHA机器人训练,但Google示范,经过微调,也能执行在第三方厂商的机器人,如德国Apptronik的Franka FR3双臂工业机器人或Apollo人型机器人。

Google并发布Gemini Robotics SDK,可帮开发人员评估Gemini Robotics On-Device用于其环境下或任务的性能泸深投,他们也可以利用Google几年前发布的MuJoCo物理模拟函数库测试模型,并快速适应其他新领域。开发人员现在只要报名加入信赖测试员计划即可访问SDK。

金鼎配资提示:文章来自网络,不代表本站观点。